L’Europe peut-elle s’imposer durablement dans la filière de l’embarqué ? Les réponses données à la 13ème édition des Assises de l’Embarqué.

L’association Embedded France regroupe les représentants français des filières de l’électronique et de l’embarqué avec l’objectif de promouvoir la compétitivité de leurs secteurs. L’association, qui est soutenue par la DGE et le Ministère de l’Economie des Finances et de la Relance, a présenté le 19 janvier dernier la 13ème édition des Assises de l’Embarqué, placée sous le prisme de la souveraineté numérique.

Au programme, l’intervention de nombre de ses membres pour présenter leurs visions et projets en open-source hardware, 5G et IA embarquée.

1. L’open-source hardware

La première table ronde fut animée par des représentants de Thales, Secure IC, Greenwaves Technologies et le Centre Aquitain des Technologies de l'Information et Électroniques, qui développent des solutions basées sur des processeurs adaptés comme le RISC-V* et l’open-source hardware.

Cela a été l’occasion d’en rappeler les atouts :

l’essor des effets communautaires et de la co-innovation

l’indépendance vis-à-vis des fournisseurs et du contexte géopolitique

l’accélération de la personnalisation et du sur-mesure pour adresser ses besoins

la réduction du time-to-market

Tout l’enjeu réside aujourd’hui dans la mise en place d’un écosystème coopératif afin de développer des solutions tirant parti de ces avantages, tout en offrant plus de robustesse et de fiabilité pour des usages industriels. D’un point de vue plus global, l’Europe doit aussi évaluer sur quels segments de la chaîne de valeur elle est capable d’investir pour assurer sa souveraineté, étant déjà bien devancée par l’Asie sur le segment hardware.

2. La 5G

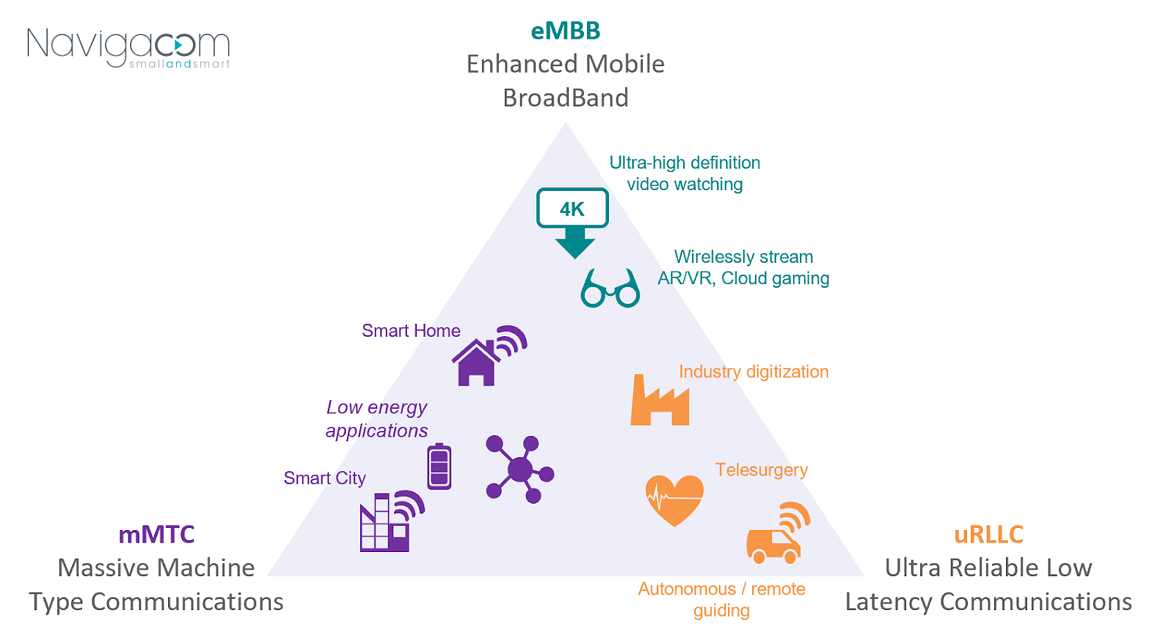

La deuxième table ronde dédiée à la 5G, ses impacts et ses enjeux donne la parole à OBS, IMT Atlantique, Renault, Viveris, Nokia ou encore Altran. Le véhicule connecté “V2X”, cas d’usage principalement évoqué, permit d’illustrer la révolution des usages cellulaires avec la notion de compromis et de “curseur à placer dans le triangle de la 5G” en fonction des trois KPI définis par la 3GPP : les très hauts débits de téléchargement (10 Gbps), la faible latence (1 ms), et le support d’objets communicants massifs (cent fois plus que la 4G). - voir le schéma ci-dessous.

Cette révolution des usages passe principalement par les technologies de “slicing” et de “Multi-access Edge Computing”, qui reposent elles-mêmes respectivement sur la virtualisation et la distribution de l’architecture réseau. Ces avancées permettent ainsi de développer des services sur mesure en termes de débit, de latence et de volume d’appareils connectés, où les capacités de calcul et de traitement peuvent être positionnées au plus près du terminal.

Aujourd’hui, tout est encore à inventer pour le management et l’hébergement des données et des applications, ainsi que pour les outils de développement et d’intégration des nouveaux services : il n’y a pas de fatalité vis-à-vis des GAFAM et l’Europe est en mesure de trouver sa place dans la course à la 5G pour garder la maîtrise des technologies clés. La France a intérêt de suivre les exemples de ses voisins allemand et anglais qui sont plus en avance.

3. L’IA

A ces innovations s’ajoute la complémentarité de l’IA embarquée qui fut l’objet de la troisième et dernière table ronde, à laquelle ont participé Renault, le Commissariat à l’Energie Atomique et aux énergies alternatives, Kalray, Ansys ou encore Mathworks. Leur problématique commune est l’intégration de systèmes intelligents de plus en plus complexes et ce au plus près du terminal, comme pour des usages automobiles qui sont critiques en termes de latence et de sécurité.

Pour ce faire, les réflexions suivantes sont essentielles :

Les données sont de plus en plus diverses (audio, signal, LiDAR, etc.) et leur pré-traitement et agrégation d’autant plus complexes. On parle de “fusion de données”. Considérant cela, Renault a par exemple pour objectif de simplifier sa gamme de produits et ainsi les différents capteurs qui y sont intégrés.

Puis c’est le volume de données disponibles pour l’auto-apprentissage du système algorithmique qui est un élément clé du succès, car dans certaines mesures, plus la quantité de données d’apprentissage est importante et plus le système sera fiable sur un grand nombre de cas, et permettra de limiter le biais de l’IA**.

Ensuite, le déploiement et l’intégration de ces briques reposent intrinsèquement sur le hardware utilisé avec l’étude de nouveaux processeurs comme les GPU***.

Enfin, la certification et la standardisation sont primordiales pour l’exploitation et la pérennité des solutions. L’idéal est de faire du standard avec les performances du sur-mesure. Des solutions apparaissent à présent : processeurs GPU, librairies Linux pour le management du Data Plane - DPDK-, services Cloud dédiés comme des fonction de circuit logique programmable “as a Service”, etc.)

Tesla qui fit le choix de développer jusqu’à leurs propres puces portant l’IA et Google avec Tensorflow**** sont donc vus comme des modèles vers lesquels tendre. Néanmoins, l’IA n’en est qu’à ses débuts, la France et l’Europe sont alors aussi en mesure de construire le futur, fortes de leur expertise dans le domaine de l’embarqué.

Et vous, avez-vous ou envisagez-vous dans votre entreprise la mise en place d’usages IoT basés sur des systèmes embarqués et/ou complexes ?

RISC-V* : architecture de jeu d’instruction ouverte et libre dédiée aux micro-processeurs de l’embarqué et des terminaux légers.

Biais de l’IA** : situation dans laquelle un système de Machine Learning discrimine un groupe de personnes en particulier, comme décrit dans une étude réalisée au MIT en 2018 montrant que les logiciels de reconnaissance faciale sont efficaces à 99% pour déterminer le genre d’une personne à condition seulement d’être un homme et d’avoir la peau blanche.

Processeur GPU*** : processeurs graphiques à l’origine développés pour le traitement de tâches de rendu 3D spécifiques mais qui tendent aujourd’hui à être utilisés également pour des traitements en parallèle plus généralistes. Nvidia est le fournisseur le plus connu.

Tensorflow**** : outil open-source de Machine Learning basé sur l’utilisation de réseaux de neurones profonds développé par Google et devenu une référence sur le marché.